Quand les algo rythment l’information

Faire vivre son média sur Facebook et Instagram nécessite une connaissance de ces outils pour gagner en visibilité ou monétiser son contenu. Face au flou imposé par les algorithmes, certain·es parlent de « censure » de publications ou de « perte de la ligne éditoriale ». Pour Médianes, la Revue Far Ouest, Clit Révolution, la revue Gaze et Loopsider témoignent de leur présence sur les réseaux sociaux.

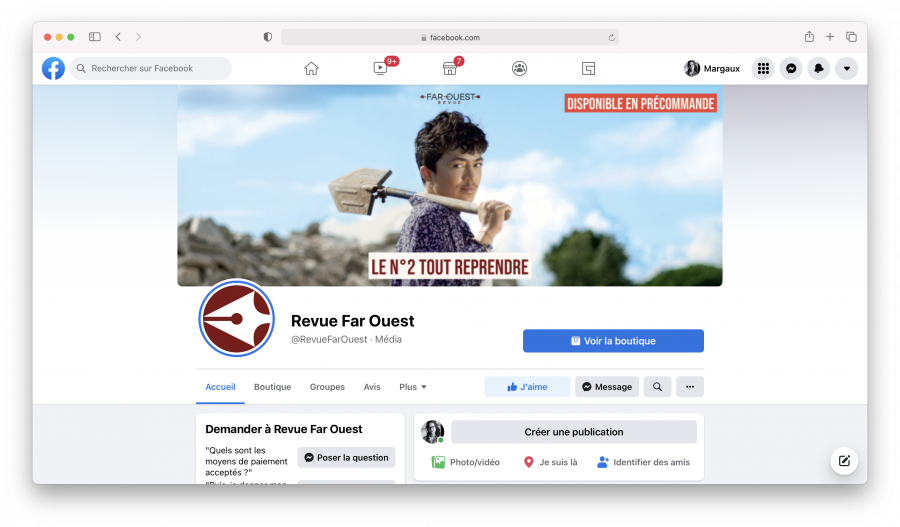

« Facebook était comme mon dealer », assène Flo Laval, co-fondateur de la Revue Far Ouest, un média indépendant qui couvre la région Nouvelle-Aquitaine. La métaphore de la drogue, il la file tout au long de notre échange. Lorsqu’un nouveau média se lance, la présence sur les réseaux sociaux est presque inévitable. Et pour l’équipe de la revue lancée en 2017, il a fallu appréhender ces usages.

Entre 2016 et 2019 c’est l’extase : le média, présent également en vidéo sur Facebook, vient de créer sa page dans le but de gagner en visibilité. « On a réussi à tripler notre communauté au fil des mois. On a bien vu que personne n’allait sur le site Internet. Donc on a émergé aussi grâce à ça », reconnaît Flo. Pour émerger sur le réseau social, la revue se plie alors aux recommandations de la plateforme « il fallait publier du contenu des vidéos d’environ 5 minutes. On abordait des sujets comme les gilets jaunes, le féminisme, l’environnement, qui plaisent aux algorithmes de Facebook donc cela générait de l’engagement ». La vidéo avec Cyril Dion cumule 180 000 vues et d’autres atteignent les 675 000 vues.

À en perdre la ligne éditoriale

Mais Flo se rend vite compte que Facebook « demande de produire toujours plus. Puis il nous montre comment payer encore plus pour gagner davantage en visibilité ». Et du jour au lendemain, tout s’arrête. La plateforme exige des vidéos plus courtes. Far Ouest perd son audience alors même que Facebook est devenu son principal canal de communication. L’équipe a conscience qu’elle s’est enfermée dans un format, au point de s’éloigner de sa ligne éditoriale initiale : prendre le temps, rencontrer les acteur·ices de l’environnement, raconter la région Nouvelle-Aquitaine. « Nous produisions du contenu pour faire plaisir à l’algorithme, personnellement j’étais dépendant d’un truc que je ne maîtrisais plus ».

Et ce truc, c’est l’algorithme. « Aujourd’hui, plus c’est court, plus ça marche. Sauf que la revue va au fond des choses. Donc avec les algorithmes, ça n’allait plus ». En effet, en 2018, Facebook a changé son algorithme, ce qui a particulièrement impacté les médias. Aussi, à ce moment-là, Facebook mise tout sur la vidéo et recommande des durées précises pour gagner en visibilité : entre 1 et 5 minutes. Par ailleurs, Facebook s’est doté d’un outil en 2014 : Facebook for media. Un site à destination des médias, conçu comme un kit ou comme un guide sur les bonnes pratiques afin d’être visible sur la plateforme. « Les invitations que lance Facebook à produire plus de vidéos sont néanmoins également assorties de conseils de nature à influer sur leur contenu », assure le chercheur Tristan Mattelart dans son article « Comprendre la stratégie de Facebook à l’égard des médias d’information ».

Alors jeune média, l’équipe de la Revue Far Ouest a testé sa présence sur les réseaux sociaux de manière empirique. « Il faut rester modeste quand on débute : tu essayes, tu fais une erreur, tu changes. Il y a un écart entre la bonne manière de faire, et les moyens dont on dispose pour travailler ».

« La censure devient politique »

Ne plus comprendre le fonctionnement de son principal outil de travail, Elvire Duvelle-Charles le subit avec Instagram à travers son compte Clit Révolution. Son livre Féminisme et réseaux sociaux : une histoire d’amour et de haine est sorti aux éditions Hors d’atteinte en février 2022. La veille de notre échange, elle était dans une librairie à la rencontre de ses lecteur·rices : « c’était une bouffée d’air que de rencontrer sa communauté hors ligne ». Cela en dit long sur le tournant qu’elle est en train de prendre concernant les réseaux sociaux. Au cours des rencontres, « la question du “shadow ban” et de la censure à l’encontre des contenus féministes revient souvent. Ma communauté commence à avoir conscience de ces problématiques ». Le shadow ban est l’invisibilisation d’un compte dans le fil de celles et ceux qui nous suivent. « Lorsqu’on est invisibilisé·e dans les algorithmes, on est moins mis en avant, sans savoir pourquoi. La censure c’est plus rare, mais plus explicite ». Mais alors pourquoi des comptes féministes seraient invisibilisés ? « Ma théorie, qui n’engage que moi, poursuit Elvire Duvelle-Charles, soupçonne les signalements en masse de nos comptes : celles et ceux qui ne supportent pas les féministes font en sorte que nous soyons régulièrement restreint·es ».

L’ambivalence se trouve dans le fait que le cyber-harcèlement est « bon pour l’algorithme » puisque la valeur d’un post est calculée en fonction du taux d’engagement que génère ce contenu. Ainsi, un post féministe sur les réseaux sociaux qui subirait un harcèlement via une avalanche de commentaires haineux pourrait « plaire » à l’algorithme de la plateforme. Malheureusement, la culture du clash provoque la mise en avant des contenus. Alors que le militantisme s’exprime aujourd’hui aussi par le clic, des comptes féministes existent depuis plusieurs années et Meta (maison mère de Facebook, Instagram et WhatsApp) a plutôt tendance à apprécier la nouveauté. Après cinq années d’existence, la visibilité baisse drastiquement, « parfois nous avons 78 likes pour 120 000 abonné·es. Le compte n’est plus mis en avant comme un nouveau peut l’être ».

Selon Elvire Duvelle-Charles, Meta ne communique pas sur ses pratiques de blocage de certains contenus : « on les découvre en postant ». Elle cite en exemple la Une de Télérama avec l’activiste et modèle Leslie Barbara Butch posant nue. Le partage de la photo a été bloqué sur les réseaux sociaux pendant plusieurs heures. De son côté, Instagram partage ses préconisations pour gagner en visibilité : la régularité des posts, la production de plusieurs contenus par jour, la publication de Reels est également recommandée. Meta veut rattraper son retard sur l’instantanéité de TikTok, mais pour Elvire c’est surtout « produire toujours plus, et c’est de la fatigue. Tenir le rythme devient infaisable et il y a le risque de perdre sa ligne éditoriale. Alors même que certain·es suivent ces recommandations, leurs contenus sont bloqués, la censure devient politique ».

En passer par la case justice

Sa manière d’appréhender les réseaux sociaux a changé. « J’ai une relation ambiguë avec les réseaux sociaux. D’un côté, je ressens un dégoût et de l’autre je continue à les utiliser ». Il y a dix ans, Elvire était chargée des réseaux sociaux dans le collectif des Femen. « Nous connaissions mieux le fonctionnement des algorithmes : le taux d’engagement du public dans les heures qui suivent la publication. Nous étions bloquées pendant un temps, car nous montrions des photos avec des tétons apparents puis la publication revenait. Maintenant, c’est une censure algorithmique ».

Pour dénoncer ces abus, Elvire Duvelle-Charles est co-signataire, avec d’autres comptes féministes, d’une tribune publiée dans Mediapart. Dans ce texte, ils et elles dénoncent « la censure grandissante de groupes militants sur les réseaux sociaux et l’absence totale de modération des contenus sexistes, racistes, appelant au cyber-harcèlement, et une silenciation permanente de nos propos » et demandent notamment « une modification de l’algorithme pour une meilleure représentation et visibilité des corps des minorités et la création d’un observatoire indépendant des réseaux sociaux, cofinancé par l’État et les plateformes ».

Tout est parti de la suppression d’une publication, de la militante féministe et antiraciste Mélusine qui posait la question : « comment fait-on pour que les hommes cessent de violer ? ». Elvire Duvelle-Charles précise que c’est aussi le point de départ d’une assignation en référée portée contre Facebook par un collectif de 14 comptes féministes dont Clit Révolution. Le collectif s’est entouré des avocates Valentine Rebérioux et Louise Bouchain. L’objectif de cette assignation est d’avoir une solution immédiate proposée. Elles demandent à ce que Facebook soit plus transparent en ce qui concerne leurs algorithmes et leur politique de modération.

___________________________________________________________________________

Nikos Smyrnaios est maître de conférences en Sciences de l’information et de la communication à l’Université de Toulouse et auteur de Les GAFAM contre l’Internet, une économie politique du numérique (INA, 2020).

Le mot « censure » revient à plusieurs reprises dans les témoignages recueillis, ce terme vous paraît-il adapté ?

Pour moi, le mot censure est de nature politique et militaire. Je parlerais plutôt de réduction de visibilité et de posts suspendus ou de mise en invisibilisation. Lorsque Facebook retire des publications, il y a tout un tas de raisons invoquées, mais cela peut relever d’une infraction aux conditions d’utilisation. Lorsqu’un média poste du contenu, il accepte toutes les conditions que pose le réseau, donc il doit se plier aux règles imposées. Mais il y a également l’enjeu de la modération. La mission est en partie assurée par des sous-traitants à l’étranger. Le contexte culturel et politique des modérateurs n’est pas le même concernant la modération. Ainsi, Facebook invoque la raison de l’erreur après coup, et la faute repose sur la sous-traitance. Une bonne manière pour Facebook de ne pas avoir à se justifier.

Des actions en justice comme cette assignation en référé de Facebook par 14 comptes féministes en 2021, peuvent-elles faire bouger les lignes ?

Je suis sceptique. C’est une bonne initiative que des médias engagent ces procédures, mais je ne suis pas certain de l’aboutissement. Il faut plutôt miser sur une solution politique comme le Digital Services Act engagé par l’Union européenne. Les plateformes devront notamment rendre leurs algorithmes publics. L’accès aux solutions est asymétrique : on a bien vu que les droits voisins et les accords passés entre les éditeurs et les plateformes ont concerné uniquement les grands médias traditionnels. Facebook News va mettre en avant ces médias et la concentration sera encore plus forte. Les médias émergents sont contraints de se plier à ces règles et doivent miser sur des solutions alternatives, compter sur leur communauté engagée.

L’affaire des Facebook Files, pose la question : Facebook a‑t-il encore la main sur ses algorithmes ?

Facebook contrôle ses algorithmes. Ce qu’il ne contrôle pas, ce sont les effets indirects. Pour la modération, des mots-clés sont spécifiquement choisis alors que le discours humain est complexe et les algorithmes ne comprennent pas la satire. On observe que les GAFAM [Google, Apple, Facebook, Amazon et Microsoft] et TikTok mettent la main sur l’évolution de l’usage de l’information. Par exemple, Facebook a changé son algorithme après l’élection américaine. De son côté, Google a longtemps montré qu’il avait la main en Espagne.

___________________________________________________________________________

« Je n’ai aucune visibilité »

Être visible sur les réseaux sociaux, c’est aussi assurer une partie de ses revenus. Gaze, une revue féministe indépendante qui célèbre la multiplicité des regards féminins en est un bon exemple. Pour mettre en avant leur média et communiquer sur leur revue papier, l’équipe a recours à de la publicité (sponsorisation) sur Instagram et Facebook, via l’outil publicitaire de la plateforme : Business Manager. Problème : ce compte est actuellement bloqué. « Là, je n’ai aucune visibilité concernant notre présence sur les réseaux sociaux puisque nous sommes littéralement bloquées, témoigne Clarence Edgard-Rosa la fondatrice, nos posts non publicitaires continuent d’être publiés, mais on ne se sait jamais à quel moment on peut être censuré·es ». En clair, impossible de savoir ce qu’acceptent ou non les algorithmes de Meta, impossible de sponsoriser leurs contenus et d’assurer la vente de leur revue.

Les blocages sont directement liés à la ligne éditoriale. Dans son troisième numéro, Gaze a vu plusieurs de ses contenus bannis sur Facebook. La couverture représente une femme portant une robe couleur chair, prise de dos, en train de se regarder dans le miroir. « Les algorithmes de Facebook croient que l’on publie du contenu interdit. Ce qui me met le plus en colère c’est que l’on me dise que la Une de ma revue est pornographique. Même la personne du service marketing de Facebook que nous avons eue au téléphone nous a dit que “oui objectivement il n’y avait rien de porno là- dedans”. Il faudrait presque demander à Meta sa validation pour savoir s’ils acceptent ou non notre prochaine couverture ».

Un ton cynique qui ne cache pas un ras-le-bol alors que c’est une énergie qui pourrait être davantage consacrée à la gestion du magazine. À chaque suppression de contenu, l’équipe tient à connaître les raisons : essayer de connaître les arguments, attendre des rendez-vous téléphoniques avec Meta et faire appel des blocages.

« Des situations ubuesques »

Gaze en viendrait à contourner la « censure » par l’autocensure. « On est là-dedans. La création des posts se fait totalement en fonction des algorithmes et des possibilités d’être censurés. Dans tous les cas, nous n’avons aucune idée de quel type de contenu peut être bloqué. On garde notre liberté de ton et de contenu pour la revue ». En réponse, Facebook apporterait deux explications différentes : celle d’une erreur ou bien la plateforme reconnaît que ces publications n’ont rien de déplacé, mais il faut les supprimer, car cela ne coïncide pas avec les algorithmes.

Pour la revue, le problème devient aussi économique : « si on ne communique pas, il y aura des répercussions sur le nombre de ventes ». C’est tout un tas de sanctions que subit Gaze assure Clarence : du contenu qui saute, des personnes qui repartagent, les publications perdent de la visibilité, des fonctionnalités qui disparaissent. Lors du lancement de son premier numéro, Gaze a organisé un live sur Instagram et Facebook. « C’était durant le premier confinement, nous n’avions pas vraiment d’autres choix, mais nous voulions faire quelque chose de qualité. Deux jours avant, on fait des essais et l’on découvre que l’accès à la fonctionnalité live était coupé. Des situations ubuesques et des anecdotes comme celle-ci j’en ai malheureusement beaucoup en stock ».

Ligne éditoriale, répercussions économiques, Clarence Edgard-Rosa souligne aussi la question politique. « C’est un problème de vision. Je ne sais même pas comment on a atteint 30 000 abonné·es sur Instagram avec tous ces obstacles ». Elle entend le fait que l’on puisse être limité sur une plateforme ouverte à toutes et tous, mais « par exemple, nous avons dû couper un portrait dans notre premier numéro, cela devient de l’autocensure. C’est un souci en particulier pour les artistes à qui nous faisons beaucoup appel. Finalement, la censure accompagne notre démarche et notre engagement ».

La non-réponse de Facebook

À la suite de ces témoignages, nous avons contacté Meta. Nous avons reçu cette réponse par mail : « Malheureusement, nous n’avons actuellement pas de porte-parole ou d’éléments autres que ceux publiés à vous partager sur ce sujet spécifique ». Edouard Braud, le responsable des partenariats médias pour Méta en France, n’a pas souhaité répondre à nos questions sans l’aval de sa direction. Le géant entend connaître les problématiques de ces comptes victimes de blocages de contenus. Pour cela, Meta a notamment sollicité des ONG qui défendent des causes publiques. Ces organisations sont aussi amenées à publier du contenu qui a pour but de sensibiliser le public à des sujets comme la sexualité ou la drogue, comparables à celles des médias cités plus hauts. Pourtant, ce contenu aussi peut être bloqué par l’algorithme. En cause toujours, des images ou des mots qui ne peuvent pas être utilisés. En 2020, soucieux ou par simple communication politique, Meta a contacté ces ONG. Le but : leur partager les bonnes pratiques afin de ne pas être bloqués par Facebook et les autres plateformes. Selon une source qui a assisté à l’une de ces rencontres en visioconférence, « il s’agissait de sortes de formations sur ce que l’on pouvait publier ou non. Depuis, aucune réponse concrète n’a été apportée au blocage de contenus visant à sensibiliser le public. Et c’est comme cela que des campagnes entières de sensibilisation ont été freinées ».

La fatigue et des solutions

« J’ai choisi la punition, je ne veux pas faire du politiquement correct, j’ai donc fait le deuil de la visibilité », confie Elvire Duvelle-Charles. Depuis un an, elle est présente sur la plateforme Patreon sur laquelle elle partage les coulisses de son émancipation d’Instagram, des contenus bonus, « mais surtout il y a de la bienveillance et de l’adhésion. J’ai 200 abonné·es. À présent, je mets un point d’honneur à rencontrer ma communauté hors ligne, à discuter avec elle et à organiser des rencontres ». Sans pour autant délaisser Instagram où elle continue de poster du contenu informatif.

Comme Elvire, d’autres créateur·ices de contenus et de médias se lassent de la cadence et des violences en ligne. Des alternatives se développent de plus en plus sur Discord, Patreon, Telegram ou encore dans la création d’une newsletter. « La question est aussi financière. Lorsque l’on fait des partenariats rémunérés sur Instagram, il faut savoir appréhender ce changement grâce à la diversification ». Et cela, elle l’entreprend à travers le documentaire Clit Révolution sur FranceTV Slash, la sortie de son livre et le podcast Hot Line produit par Nouvelles Écoutes. « On trouve des alternatives, je veux maintenant mettre ma visibilité au service des autres ».

De son côté, la Revue Far Ouest a choisi de faire une pause sur les réseaux sociaux. « En ce moment, nous réfléchissons à une nouvelle stratégie de notre présence sur les plateformes et cela créer du débat au sein de l’équipe », avance Flo Laval. Pour le moment, le média se recentre sur la formule papier et sur la newsletter. En effet, la revue peut compter sur sa communauté plus restreinte, mais engagée, avec qui l’équipe peut avoir un lien direct et des retours sur le travail journalistique.

Loopsider, aller là où va le public

Cependant, tous les médias ne sont pas en confrontation avec les plateformes et certains misent même sur eux. C’est le cas de Loopsider qui, dès son lancement en 2018, a parié sur une visibilité 100 % réseaux sociaux et qui compte 2 millions d’abonné·es sur sa page Facebook. Lancé notamment par Johan Hufnagel avec quatre autres associé·es, le média entend aller là où va le public sur des sujets qui parlent aux jeunes. « Notre modèle repose sur les réseaux sociaux et du brand content », explique Harold Grand, chef d’édition à Loopsider.

Le média revendique qu’il n’y a pas de lien entre la plateforme et la ligne éditoriale. « On cherche à raconter de nouveaux récits dans des vidéos courtes de 3 minutes et sur Facebook on peut monétiser avec des vidéos de cette durée ». Construire son modèle de média sur une plateforme c’est aussi construire son audience selon les algorithmes de Facebook. Mais alors, comment savoir si une vidéo va fonctionner ou non ? « Une fois publiée, on ne sait pas si une vidéo va fonctionner. Par exemple, un témoignage face caméra ou l’atterrissage spectaculaire d’un avion ont cartonné. À l’inverse, quand on se dit que tel sujet va trouver l’audience, cela peut ne pas être le cas et parfois on a des surprises », poursuit Harold Grand.

Loopsider, également aux manettes de Period, a lancé il y a quelques semaines une série sur l’éducation, l’artisanat et le logement. Des sujets qui parlent à leur audience puisque « le public est au rendez-vous ». Contrairement aux précédents témoignages, Loopsider n’a connu que très peu de blocages de leurs contenus. « Ça peut arriver et dans ces cas-là on ne comprend pas pourquoi. On ne met jamais de nudité ou de contenus violents donc nous n’avons pas vocation à être bloqués. Pour les images violentes, on floute ce qui doit l’être et on met un badge de prévention ». Comme il n’y a pas d’abonné·es au sens propre du terme, le média bénéficie d’une équipe dédiée qui travaille sur l’audience. Elle est chargée de regarder les chiffres des vidéos image par image, seconde par seconde. « Dans tous les cas, un média qui mise sur les réseaux sociaux est en perpétuel mouvement, nous devons tester de nouvelles choses. Actuellement, nous essayons des formats sur TikTok ».

TikTok devient le nouveau terrain de jeu des médias qui tentent de séduire les plus jeunes, que 7 % des moins de 35 ans utilisent pour s’informer (selon le Digital News Reports 2021). Mais tout comme Meta, le réseau social est accusé de bloquer certains contenus LBGT ou ceux comportant le hashtag Black Lives Matter. Un cercle vicieux des réseaux sociaux que combattent des médias engagés.

NDLR : Médianes, le studio, a collaboré avec la Revue Far Ouest pour l’organisation du Festival Imprimé et les accompagne dans leur positionnement stratégique.

________________________________________________________________

Aller plus loin :

- Comprendre les pratiques de Facebook à l’égard des médias, c’est aussi s’intéresser à l’évolution historique de la plateforme et de son rôle dans l’information mondiale. Le chercheur Tristan Mattelart s’est penché sur la question dans son article : « Comprendre la stratégie de Facebook à l’égard des médias d’information », Sur le journalisme, About journalism, Sobre jornalismo [En ligne, online], Vol 9, n°1 — 2020

- Dominique Cardon, Culture numérique, Paris, Presses de Science-Po, 2019.

La newsletter de Médianes

La newsletter de Médianes est dédiée au partage de notre veille, et à l’analyse des dernières tendances dans les médias. Elle est envoyée un jeudi sur deux à 7h00.